Файл: Теория Вероятности ответы на экзамен Элементы комбинаторики размещения, сочетания, перестановки Комбинаторика.docx

ВУЗ: Не указан

Категория: Не указан

Дисциплина: Не указана

Добавлен: 20.03.2024

Просмотров: 21

Скачиваний: 0

ВНИМАНИЕ! Если данный файл нарушает Ваши авторские права, то обязательно сообщите нам.

Теория Вероятности ответы на экзамен

1.Элементы комбинаторики: размещения, сочетания, перестановки

Комбинаторика - Раздел математики, посвящённый решению задач, связанных с выбором и расположением элементов некоторого множества в соответствии с заданными правилами.

1.Размещение -

2.Перестановка -

3.Сочетания -

Следствие .Число сочетаний из n эл-ов по n – m равно числу сочетаний из n элементов по m,т.е.

2.Случайные события,случайный эксперимент:операции над событиями

Случа́йное собы́тие — подмножество множества исходов случайного эксперимента; при многократном повторении случайного эксперимента частота наступления события служит оценкой его вероятности.

Случайный опыт (эксперимент, наблюдение, испытание) это некоторое действие, которое можно повторить большое количество раз в одинаковых условиях, а результат этого действия зависит от случая и его невозможно предсказать. Примерами случайных испытаний являются подбрасывание монеты, покупка лотерейного билета, вытаскивание карты из колоды, стрельба по мишени.

-

Два события тождественны друг другу (А=В) тогда и только тогда, когда эти события состоят из одних и тех же элементарных событий (точек). -

Суммой (или объединением) двух событий А и В называется событие А+В (или ), происходящее тогда и только тогда, когда происходит или А, или В. Сумме событий А и В соответствует объединение множеств А и В

), происходящее тогда и только тогда, когда происходит или А, или В. Сумме событий А и В соответствует объединение множеств А и В -

Произведением (или пересечением) двух событий А и В называется событие АВ (или ), происходящее тогда и только тогда, когда происходит и А, и В. Произведению событий А и В соответствует пересечение множеств А и В.

), происходящее тогда и только тогда, когда происходит и А, и В. Произведению событий А и В соответствует пересечение множеств А и В. -

Событие называется противоположным к А, если оно происходит тогда и только тогда, когда А не происходит. Геометрически – это множество точек квадрата, не входящее в подмножество А.

называется противоположным к А, если оно происходит тогда и только тогда, когда А не происходит. Геометрически – это множество точек квадрата, не входящее в подмножество А. -

Два события называются несовместными, если их одновременное появление в опыте невозможно. Следовательно, если А и В несовместны, то их произведение – невозможное событие:

-

Разностью событий А и В называется событие А\В (или ), происходящее тогда и только тогда, когда происходит А, но не происходит В.

), происходящее тогда и только тогда, когда происходит А, но не происходит В.

3.Понятие вероятности. Свойства вероятности.

Вероя́тность — степень (относительная мера, количественная оценка) возможности наступления некоторого события. Когда основания для того, чтобы какое-нибудь возможное событие произошло в действительности, перевешивают противоположные основания, то это событие называют вероятным, в противном случае — маловероятным или невероятным.

Свойства вероятности:

-

Вероятность достоверного события равна единице. -

Вероятность невозможного события равна нулю. -

Вероятность случайного события есть положительное число, заключенное между нулем и единицей. -

Таким образом, вероятность любого события удовлетворяет двойному неравенству 0 ≤ P (A) ≤ 1.

4.Теорема сложения вероятностей.

Теорема о сложении вероятностей звучит так: вероятность появления одного из двух несовместных событий равна сумме вероятностей этих событий: P (A + B) = P (A) + P (B).

5.Условная вероятность.Теорема умножения вероятностей.

Условная вероятность- называется вероятность событи В,вычисленная в предположении,что событие А уже наступило.

Обозначается Ра(В)

Ра(В) = Р(В/А) = Р(АВ)/Р(А)

Теорема умножения вероятностей:

Т1.Вероятность совместного появления двух событий равна произведению вероятности одного из них на условную вероятность другого.

Р(АВ) = Р(А)*Р(В/А)

Т2.Вероятность совместного появления двух событий равна произведению их вероятностей.

Р(АВ) = Р(А)*Р(В)

6.Геометрическая вероятность.

Геометрической вероятностью некоторого события называется отношение

P (A) = g/G

где G – геометрическая мера, выражающая общее число всех равновозможных исходов данного испытания, а g – мера, выражающая количество благоприятствующих событию A исходов.

7.Формула полной вероятности

Пусть Н1,Н2,..,Нn – группа гипотез. Пусть событие А наступит лишь при условии появления одной из гипотез.

Тогда вероятность события А равна:

Р(А) = Р(Н1)*Р(А|Н1)+Р(Н2)*Р(А|H2)+ … + P(Hn)*P(A|Hn)

8.Формула Байеса

Теорема Байеса (или формула Байеса

) — одна из основных теорем элементарной теории вероятностей, которая позволяет определить вероятность события при условии, что произошло другое статистически взаимозависимое с ним событие. Другими словами, по формуле Байеса можно более точно пересчитать вероятность, взяв в расчёт как ранее известную информацию, так и данные новых наблюдений.

Формула Байеса:

{\displaystyle P(A\mid B)={\frac {P(B\mid A)\,P(A)}{P(B)}}}Р(A|B) = P(B|A)*P(A) / P(B)

где

P(A){\displaystyle P(A)} — априорная вероятность гипотезы A (смысл такой терминологии см. ниже);

P(A|B){\displaystyle P(A\mid B)} — вероятность гипотезы A при наступлении события B (апостериорная вероятность);

P(B|A){\displaystyle P(B\mid A)} — вероятность наступления события B при истинности гипотезы A;

P(B){\displaystyle P(B)} — полная вероятность наступления события B.

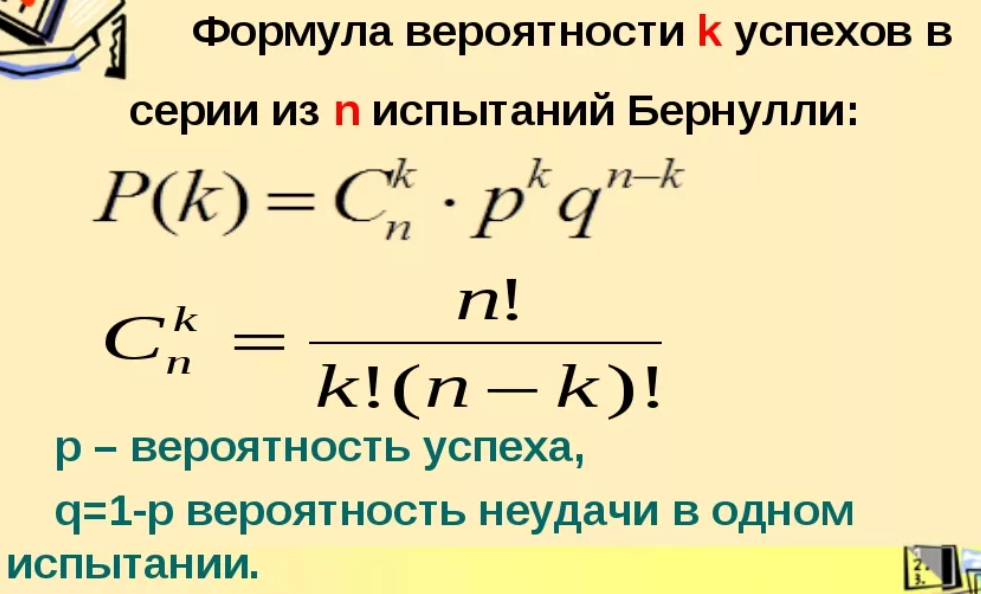

9.Повторные независимые испытания.Схема Бернулли.

Если производится несколько испытаний, причем вероятность события А в каждом испытании не зависит от исходов других испытаний, то такие испытания называют независимыми относительно события А.

Если независимые повторные испытания проводятся при одном и том же комплексе условий, то вероятность наступления события А в каждом испытании одна и та же.

10.Наивероятнейшее число наступлений события в серии.

Число наступлений события в независимых испытаниях называется наивероятнейшим, если вероятность наступления события данное число раз в этой серии испытаний наибольшая по сравнению с вероятностями других исходов.

Наивероятнейшее число события удовлетворяет неравенствам

– (np – q) = p + q = 1, то всегда существует целое число k0, удовлетворяющее приведенному выше двойному равенству.

Причем, если:

1) (np – q) – целое число, то наивероятнейших чисел два: k0 = np –

– q и k0 = np + p;

2) np – целое, то наивероятнейшее число k0 = np;

3) np – q – дробное, то существует одно k0.

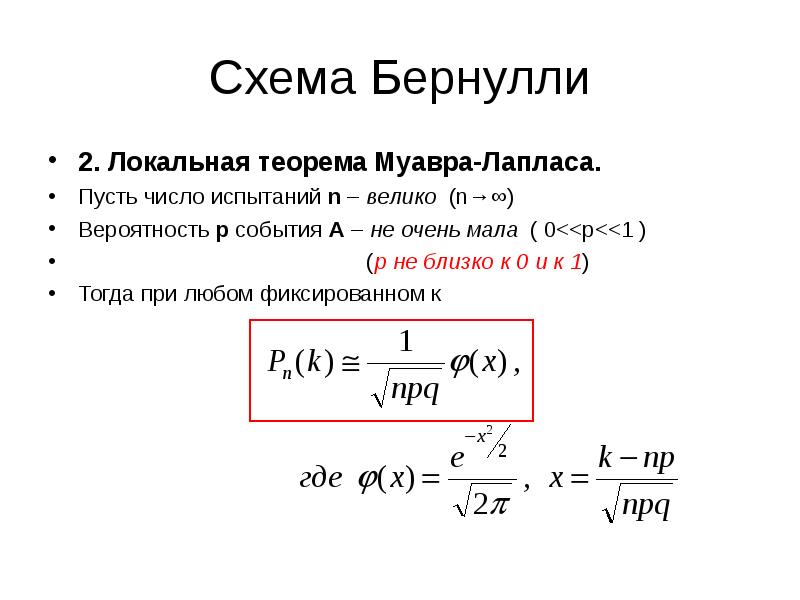

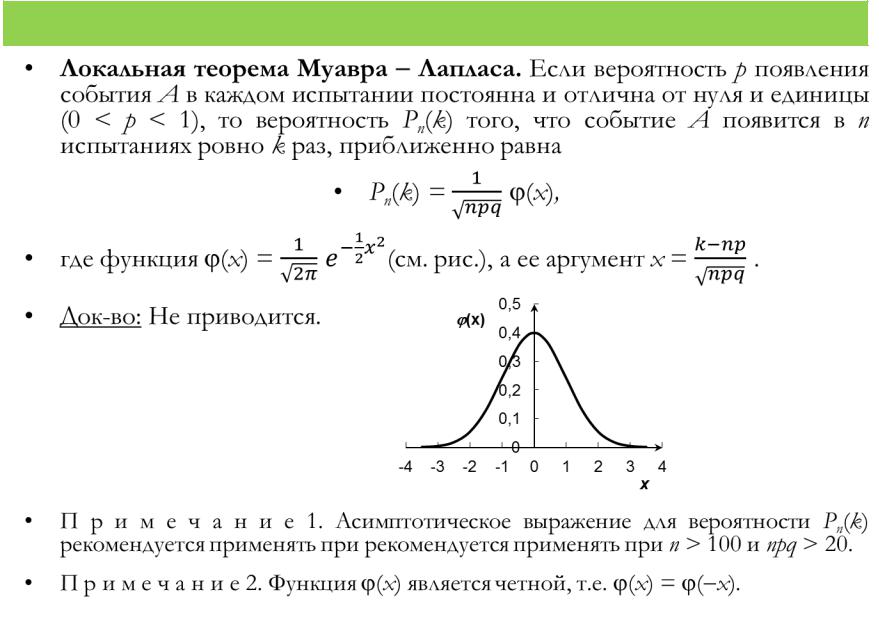

11.Локальная теорема Лапласа.

12.Формула Пуассона

Распределение дискретного типа случайной величины, представляющей собой число событий, произошедших за фиксированное время, при условии, что данные события происходят с некоторой фиксированной средней интенсивностью и независимо друг от друга.

Пусть Л= n*p,является постоянной величиной,когда n ,неограниченно возрастает.Тогда для любого фиксированного m и любого постоянного Л,верно равенство:

Lim Pn(m) = (Л^m / m!)*e^-Л

n->00

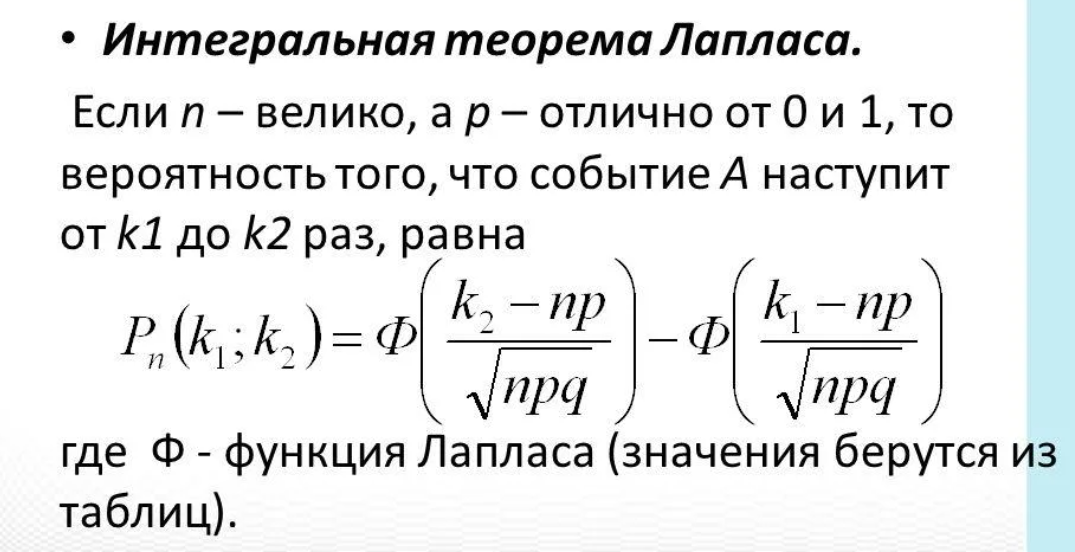

13.Интегральная теорема Лапласа.

Если при каждом из n независимых испытаний вероятность появления некоторого случайного события E равна p ∈, и m - число испытаний, в которых E фактически наступает, то вероятность справедливости неравенства близка к значению интеграла Лапласа.

Ф-ция Ф(х) – называется ф-цией Лапласа. Она затабулирована и ее значения от 0 до 5.

Данная ф-ция не четная :Ф(-х)=-Ф(х) .

14.Закон и функции распределения СВ,и ее свойства.

Случайной величиной называется величина, которая может принимать то или иное значение, неизвестное заранее.

Законом распределения случайной величины называется всякое соотношение, устанавливающее связь между возможными значениями случайной величины и соответствующими им вероятностями. Про случайную величину говорят, что она подчинена данному закону распределения.

n

∑ = рi = 1

i=1

Фу́нкция распределе́ния в теории вероятностей — функция, характеризующая распределение случайной величины или случайного вектора; вероятность того, что случайная величина X примет значение, меньшее х, где х — произвольное действительное число. При соблюдении известных условий полностью определяет случайную величину.

Свойства СВ:

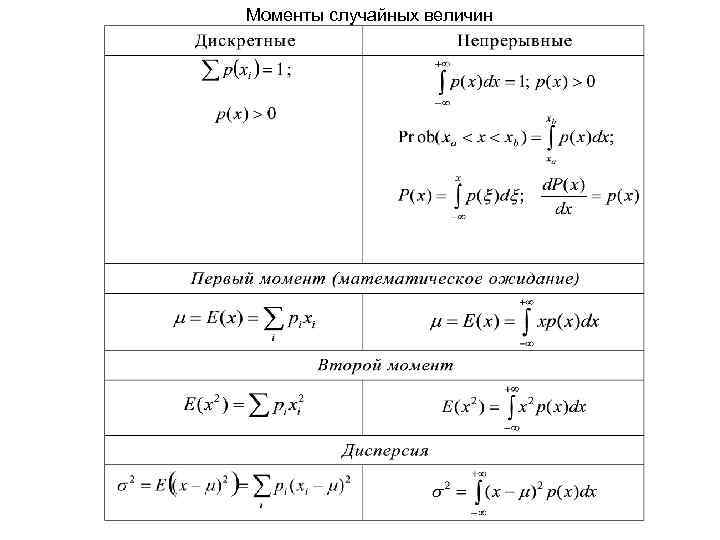

1.Математическое ожидание— это сумма всех возможных ее значений, помноженных на их вероятность. Говоря простым языком, это «среднее значение» принимаемой случайной величины.

2.Дисперсия — мера разброса значений случайной величины относительно её математического ожидания.

3.Среднеквадратическое отклонение — показатель рассеивания значений СВ относительно ее математического ожидания.

15.Дискретные и непрерывные СВ.

Дискретная СВ - СВ, которая принимает отдельное изолированные друг от друга значения, с определенными вероятностями.

Она может принимать конечные и бесконечные счетное число значений.

Примеры: Появление герба, при подбрасывании монеты

Если само пр-во w,является конечным или счётным, то любая СВ на w,будет дискретная.

Операции над дискретной СВ:

1.Сумма СВ Z= X + Y

2.Две СВ Х и Y – независимы, если события независимы для всех значений хi и yi.В этом случае:

Pij= P(X=xi)*P(Y=yi).

3.Разность СВ Z = X-Y

4.Произведение СВ Z = X*Y

Независимая СВ – если ее ф-ция распределения непрерывна в любой точке и дифференцируема всюду, кроме быть может, отдельных точек.

Непрерывная СВ принимает 00 несчетное число значение.

Примеры: рост человека, изменение симметрии лица, диаметр деталей, которые затачивают.

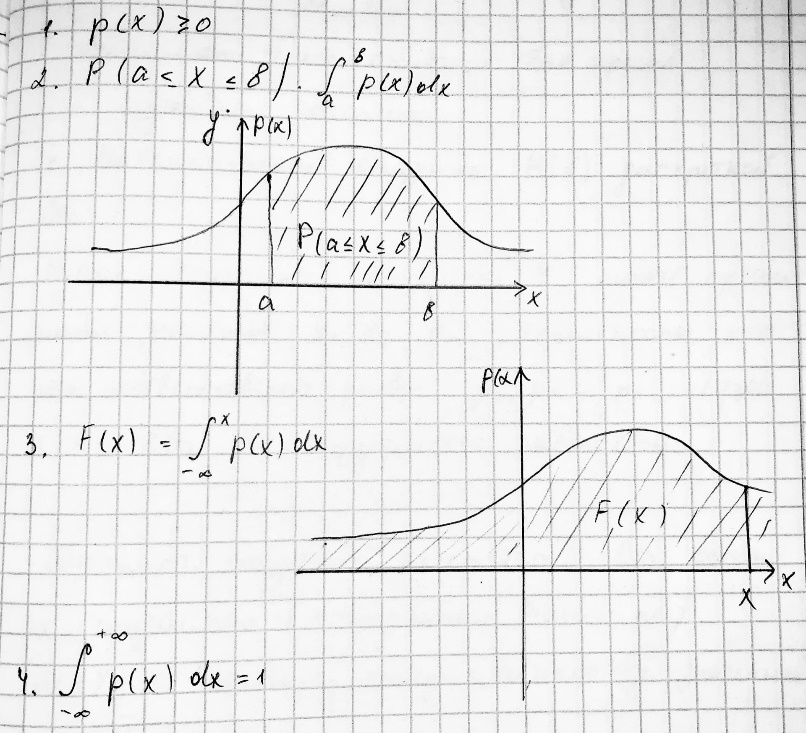

16.Плотность распределения вероятностей и ее свойства.

Плотность распределения вероятностей – это отношение вероятности Р(а

Р(а

Плотность вероятности иногда называется дифференциальной ф-цией.

График плотности вероятности называется кривой распредления.

Свойства:

17.Операции над несколькими СВ

Суммой (разностью, произведением) этих случайных величинназывается дискретная СВZ=X+Y(Z=X–Y,Z=X*Y), принимающая значенияzij = xi+yj(zij = xi–yj;zij = xiyj) с вероятностямиpij=P(X=xi;Y=yj) для всех указанных значенийiиj. В случае совпадения некоторых суммxi+yj(разностейxi–yj, произведенийxiyj) соответствующие вероятности складываются.

Произведением дискретной СВ X на число с называется дискретная случайная величинасX, принимающая значениясxiс вероятностямиpi=P(X=xi).

Аналогично определяются сумма и произведение любого конечного числа дискретных случайных величин.

18.Математическое ожидание дискретной и непрерывной СВ.

Это сумма вероятностей умноженных на СВ Х

M(X) = Σ xi*pi.

Свойства М(Х) :

-

М(Х) постоянной величины равно самой постоянной: М(С)=С, где С =const -

Постоянны1й множитель можно выносить за знак: М(С*Х)=С*М(Х),где С =const -

М(Х) алгебраической суммы конечно числа СВ равно алгебраической сумме их М(Х):

М(Х+-Y) = М(Х) +- М(Y), каждое Х,Y

-

М(Х) произведения конечного чмсла независимых СВ равно произведению их М(Х)

М(Х*Y) = М(Х) * М(Y), каждое Х,Y

-

М(Х) отклонения СВ от её М(Х) равно нулю: М(Х- М(Х))=0

М(Х) непрерывной СВ Х,возможные значения которой пренадлежат всей оси Ох, определяется равенство:

М(Х) = интеграл от +00 до -00 хр(х) dx(если интервал, то от а до b)

p(x)- плотность распределения СВ Х

Предполагается что интервал сходится абсолютно!

19. Дисперсия СВ и ее свойства

Дисперсия СВ Х – называется М(X) квадрата её отклонения от её М(X):

D(X)= М((Х-М(Х))^2

Свойства D(X):

-

D(X) постоянной величины С равна нулю:

D(С)= 0

2.Постоянный множитель можно выносить за знак дисперсии, возводя его в квадрат:

D(СX)= С^2* D(X)

3.D(X) суммы двух независимых СВ равна сумме D(X) этих величин:

D(X+ Y) = D(X)+ D(Y)

4. D(X) разности двух независимых СВ равна их сумме D(X):

D(X-Y) = D(X)+ D(Y)

5.Для оценки рассеяния возможных значений СВ вокруг ее среднего значения вводится – среднее квадратическое отклонение:

σ = корень из D(X)

Для непрерывной СВ D(X) равна:

D(Х) = интеграл от +00 до -00 X – M(X)*р(х) dx

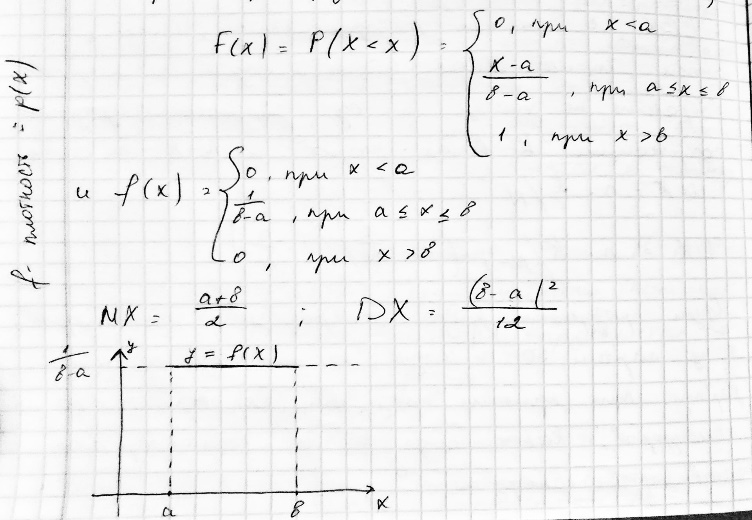

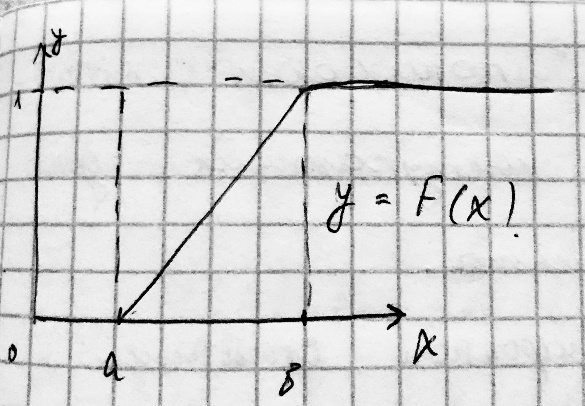

20. Равномерно распределенная СВ

СВ Х имеет равномерное распределение на отрезке [a,b],равномерное распределение (X пренадлежит Uab),если:

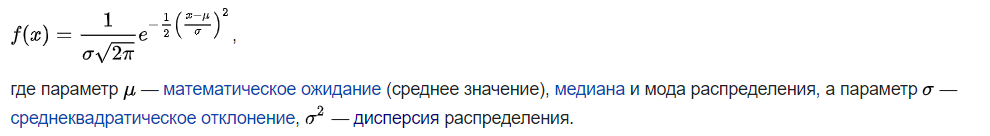

21.Нормальный закон распределения

Норма́льное распределе́ние[1][2], также называемое распределением Гаусса или Гаусса — Лапласа[3], или колоколообразная кривая — непрерывное распределение вероятностей с пиком в центре и симметричными боковыми сторонами, которое в одномерном случае задаётся функцией плотности вероятности, совпадающей с функцией Гаусса:

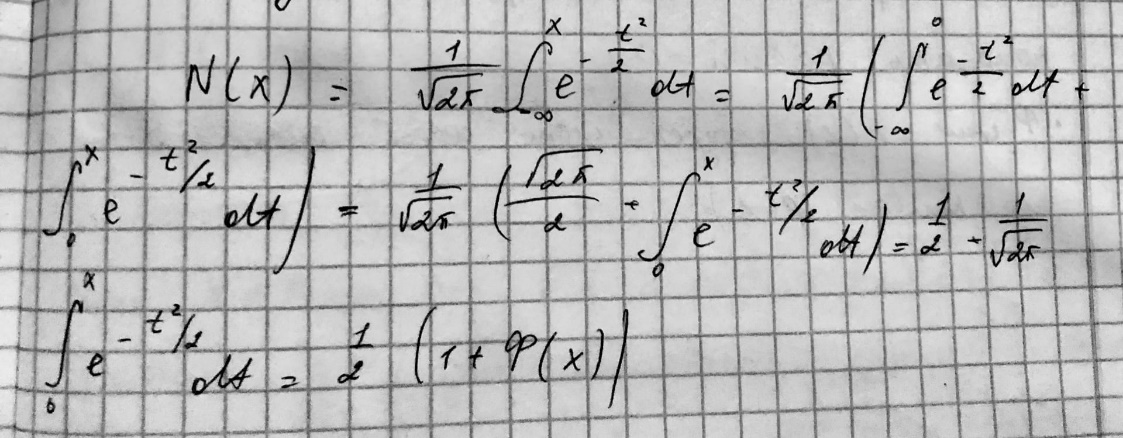

Стандартным нормальным распределением называется нормальное распределение с математическим ожиданием {\displaystyle \mu =0}М(Х)=0 и стандартным отклонением {\displaystyle \sigma =1.} σ=1.

Для стандартного нормального распределения ф-ция распространения имеет вид:

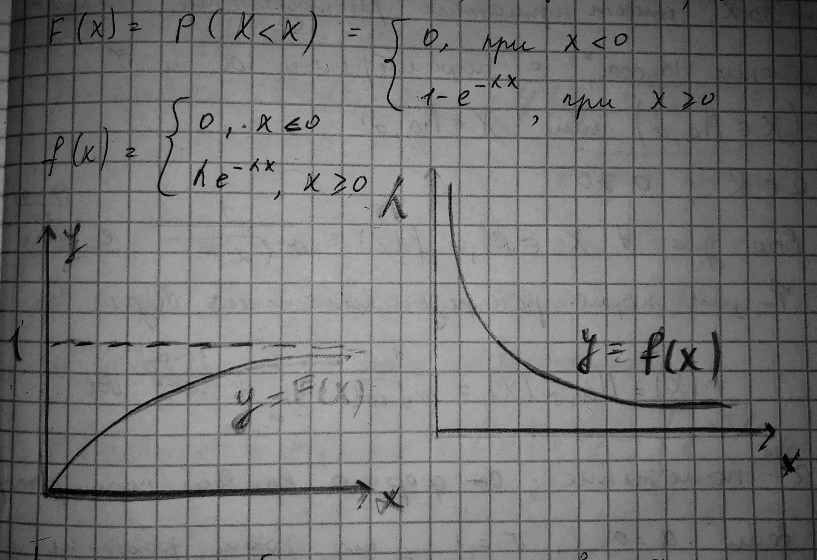

22.Экспоненциальный закон распределения.

СВ Х имеет показательное распределение с параметром Л,обозначают nP – (X пренадлежит Ел),где Л>0,если :

Встречается в задачах с потоком событий (последовательность событий,наступающтх одно за другим,в случайные моменты).

23.Вероятность попадания значения нормально распределённой СВ,в заданный интервал,правило трёх сигм.

Пусть СВ распределена по нормальному закону. Тогда вероятность того, что Х примет значение, принадлежащее интервалу равна:

P(α

Правило 3-х сигм:

Практически все значения норм. распределённой СВ лежат в интервале

Более строго – приблизительно с 99,73% вероятность значения норм. распределённой СВ лежит а указанном интервале.

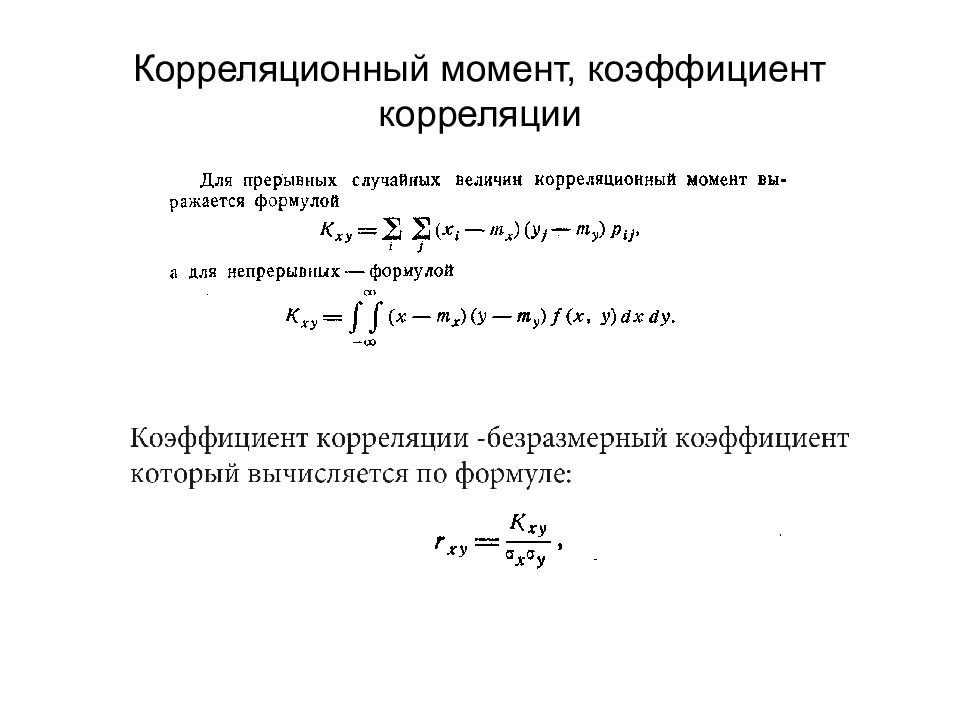

24.Двумерная СВ.Закон распределения и ф-ция распределения двумерной СВ.Ковариация.

Двумерной называют случайную величину (Х, Y), возможные значе-ния которой есть пары чисел (х, у). Составляющие Х и Y, рассматриваемые одновременно, образуют систему двух случайных величин.

Законом распределения дискретной двумерной случайной величины называют перечень возможных значений этой величины, то есть пар чисел.

F (x; y) = P (x < x, y < y)

Функция распределения двумерной случайной величины (Х, Y) определяется соотношением F (x; y) = P (X < x, Y < y) и геометрически определяет вероятность попадания случайной точки (Х, Y) в бесконечный квадрат с вершиной в точке (Х, Y), лежащий левее и ниже ее.

Дискретной называют двумерную величину, составляющие которой дискретны; непрерывной называют двумерную величину, составляющие которой непрерывны.

Ковариация — это мера зависимости между двумя или более случайных переменных.

25.Зависимые и независимые СВ

Зная законы распределения случайных величин Х и Y, входящих в систему

(X, Y), можно найти закон распределения системы только в том случае, когда

случайные величины Х и Y независимы.

Определение. Две случайные величины называются независимыми, если закон

распределения каждой из них не зависит от того, какие значения принимает другая.

В противном случае случайные величины называются зависимыми.

Определение. Случайные величины Х и Y называются независимыми, если

независимыми являются события {X < x} и {Y < y} для любых вещественных х и у.

В противном случае случайные величины называются зависимыми.

Условие независимости случайных величин:

Теорема. Для того, чтобы случайные величипы Х и Y были независимыми,

необходимо и достаточно, чтобы функция распределения системы (Х, Y) была равна

произведению функций распределения составляющих:

F(x,y) = F1 (x) * F3(y).

Доказательство. Если СВ Хи Y независимы, то события {X< x} и {Y < y}

независимы. Следовательно,

P{X

Cвойства ковариации:

1.Ковариация симметрична, т.е.

2. Имеют место равенства:

Эти равенства прямо следуют из определения дисперсии и равенство (38) соответственно при

3. Справедливы равенства:

Эти равенства выводятся из определения дисперсии, ковариации с.в.

По определению дисперсии (с учётом централизованности с.в.

теперь, на основании и свойств 2 и 3, получим первое (со знаком плюс) свойство 3.

Аналогично, вторая часть свойства, выводится из равенство

4. Пусть

27.Моменты СВ.

Моме́нт случа́йной величины́ — числовая характеристика распределения данной случайной величины.

28.Неравенство Маркова и Чебышева

Неравенство Маркова:

Пусть Х – СВ,принимающая неотрицательные хначения М(Х) – ее конечное мат.ожидание,то для любых а>0 выполняется условие:

Р(Х>=a)<=M(X)/a

Альтернативная форма записи: Р(Х1 - M(X)/a

Неравенство Чебышева

Пусть СВ Х имеет конечные мат.ожидание М(Х) и дисперсию D(X).Тогда для любого положительного числа x справедливо неравенство: р(|X-М(Х)|

29.Задачи математической статистики.

Основными задачами математической статистики является:

· указание способов сбора и группировки статистических сведений, полученных в результате наблюдений или в результате специально поставленных экспериментов;

· разработка методов анализа статистических данных в зависимости от целей исследователя;

· построение научно-обоснованных выводов и рекомендаций.

30.Вариационные ряды.Числовые характеристики вариационных рядов.

Вариационный ряд – ряд,в котором сопоставлены(по степени возрастания или убывания) варианты и соответствующие им частоты.

Частостью(Wi) – называется отношение её частоты к объему выборки : Wi = mi/n

К числовым характеристикам вариационного ряда относятся:

средняя арифметическая, дисперсия, начальные и центральные моменты вариационного ряда, коэффициенты асимметрии и эксцесса.

As X= м3*x/( σ *x)^3 - ассиметрия Ek X= м4*Х/( σ *x)^4 или м4*Х/D(X)^2 - эксцесс

Основные показатели среднего уровня вариационного ряда

При изучении особенностей статистического распределения прежде всего следует найти его центральное значение, т.е. средний уровень.

31. Основные числовые характеристики статистического распределения.

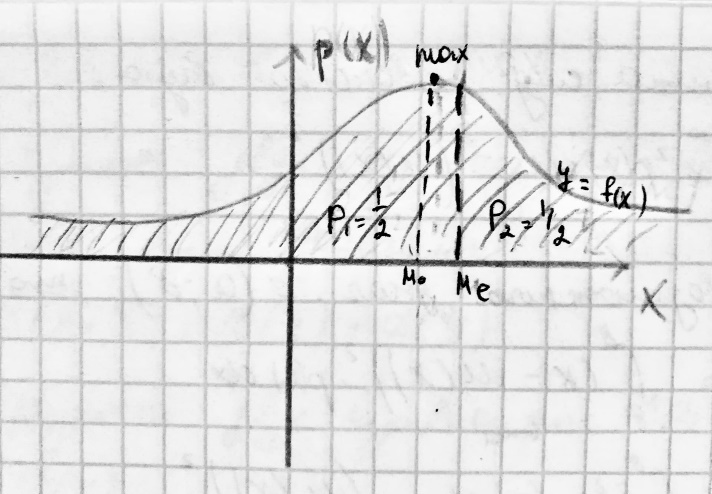

Мода М0(Х) – непрерывная СВ называется ее наиболее вероятное значение ,т.е. для которого р(х)-плотность распределения достигает максимума.

Если Р или р(х) достигает максимума,не в одной,а в нескольких точках распределения,то распределением называется – полимодальным.

Медианой Ме(Х) – непрерывная СВ называется такое ее значение для которого:

Р(Х

Вертикальная прямая х=Ме(х),проходящая через точку с абсциссой равной медиане.

Геометрически делит площадь фигуры под кривой распределения на две равные части.

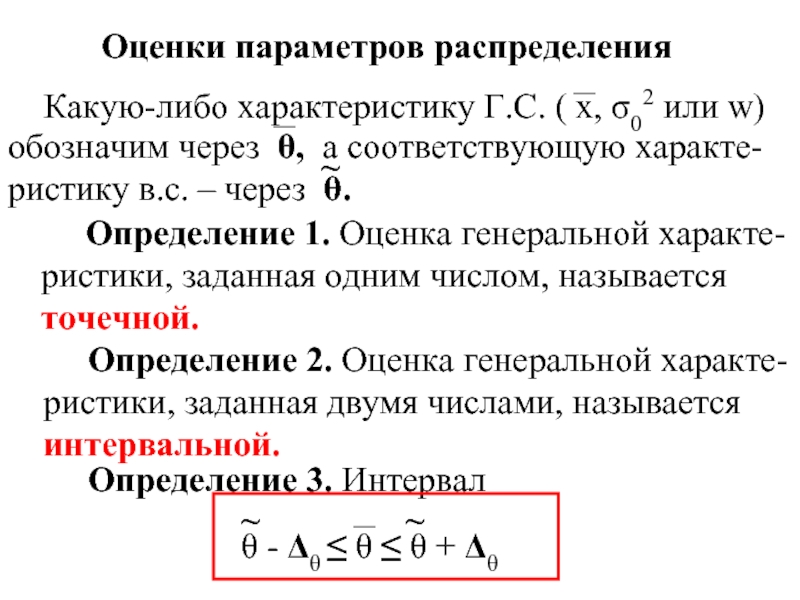

32.Генеральная и выборочная совокупность. Оценки параметров распределения.

Генеральная совокупность – это совокупность всех без исключения единиц изучаемого объекта, всех единиц, которые соответствуют цели исследования.

Выборочная совокупность (выборка) – это часть единиц генеральной совокупности, отобранная специальным методом и предназначенная для характеристики всей генеральной совокупности.

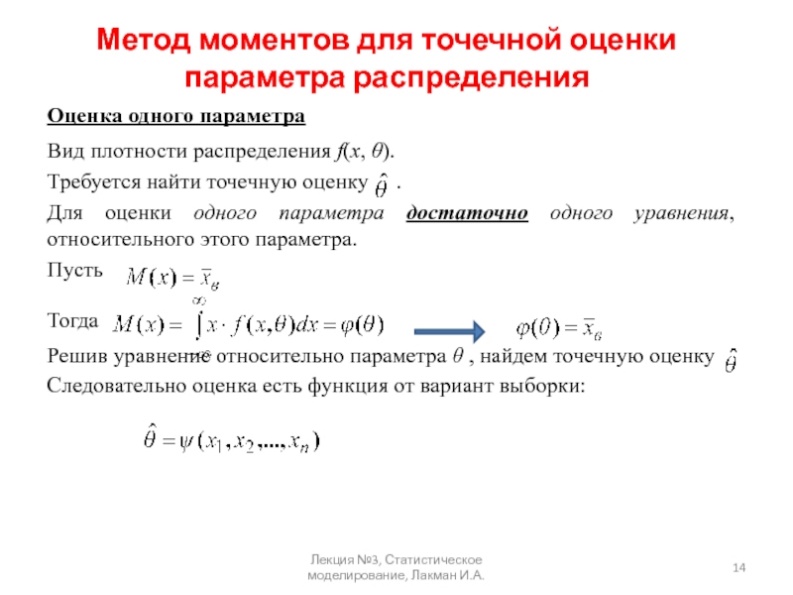

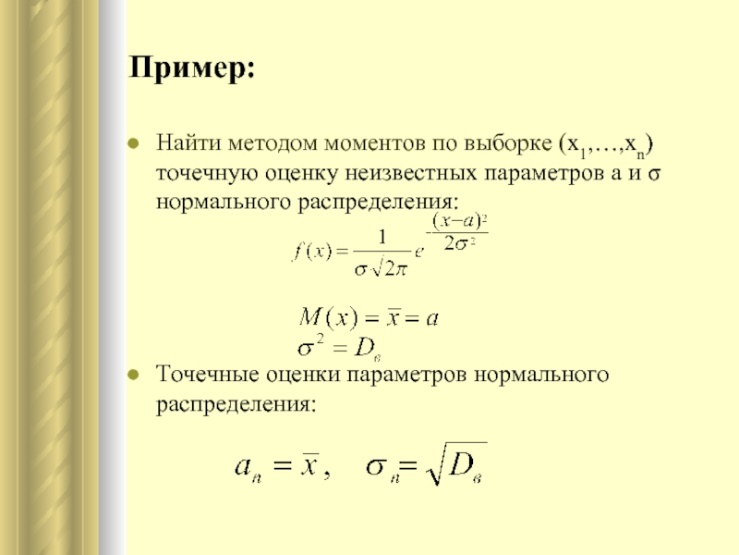

33.Выборочный метод,точечное оценивание параметров распределения.

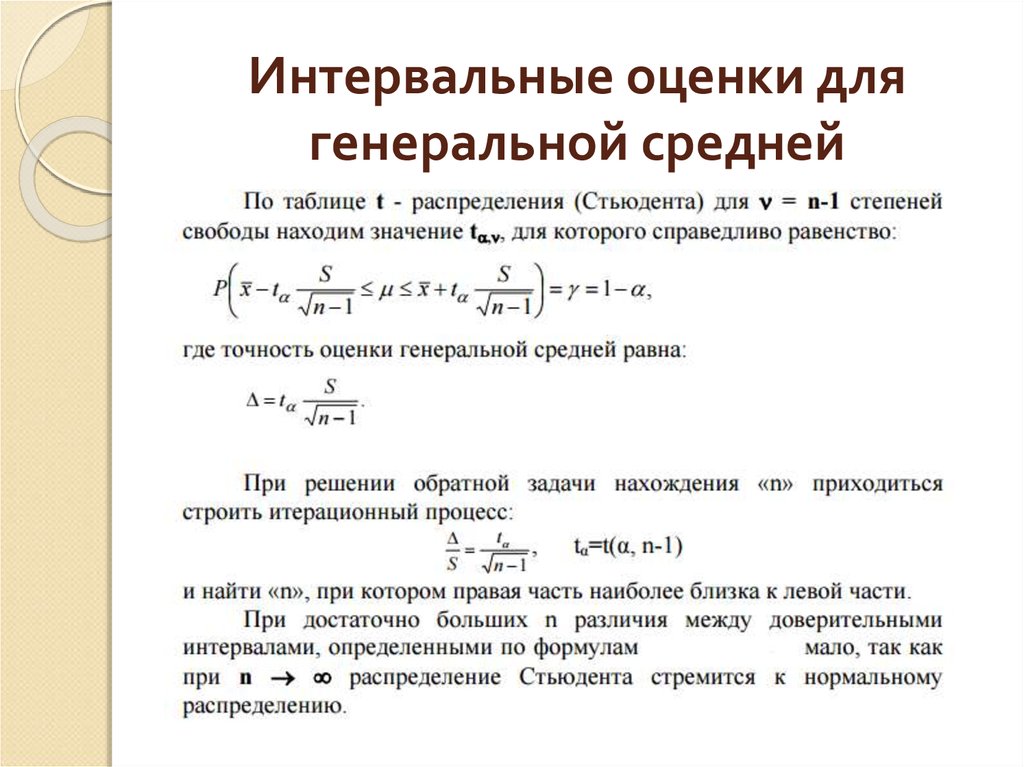

34.Интервальное оценивание параметров распределения.Доверительная вероятность и доверительный интервал.

Интервальный метод оценивания параметров распределения случайных величин заключается в определении интервала (а не единичного значения), в котором с заданной степенью достоверности будет заключено значение оцениваемого параметра. Интервальная оценка характеризуется двумя числами – концами интервала, внутри которого предположительно находится истинное значение параметра

Доверительная вероятность показывает, с какой вероятностью случайный ответ попадет в доверительный интервал. Для простоты можно понимать её как точность выборки. Как правило, используется 95%, но при низких бюджетах ее можно уменьшить до 90% или 85%.Это приведет к снижению точности, что нужно учесть в выводах.

Доверительный интервал - это допустимое отклонение наблюдаемых значений от истинных Размер этого допущения определяется исследователем с учетом требований к точности информации. Если увеличивается допустимая ошибка, размер выборки уменьшается, даже если уровень доверительной вероятности останется равным 95%. Доверительный интервал показывает, в каком диапазоне расположатся результаты выборочных наблюдений

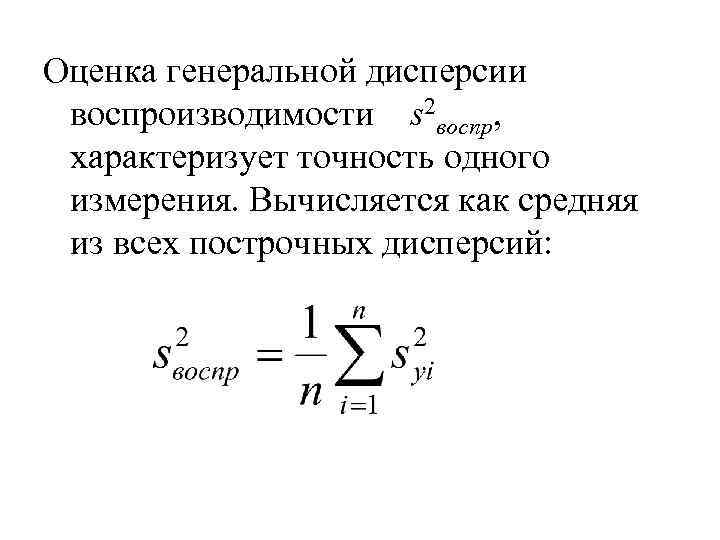

35.Оценки для генерального среднего и генеральной дисперсии.

36.Статические гипотезы. Нулевая и альтернативная гипотезы. Ошибки 1-го и 2-го рода при проверке гипотез. Уровень значимости. Мощность критерия.

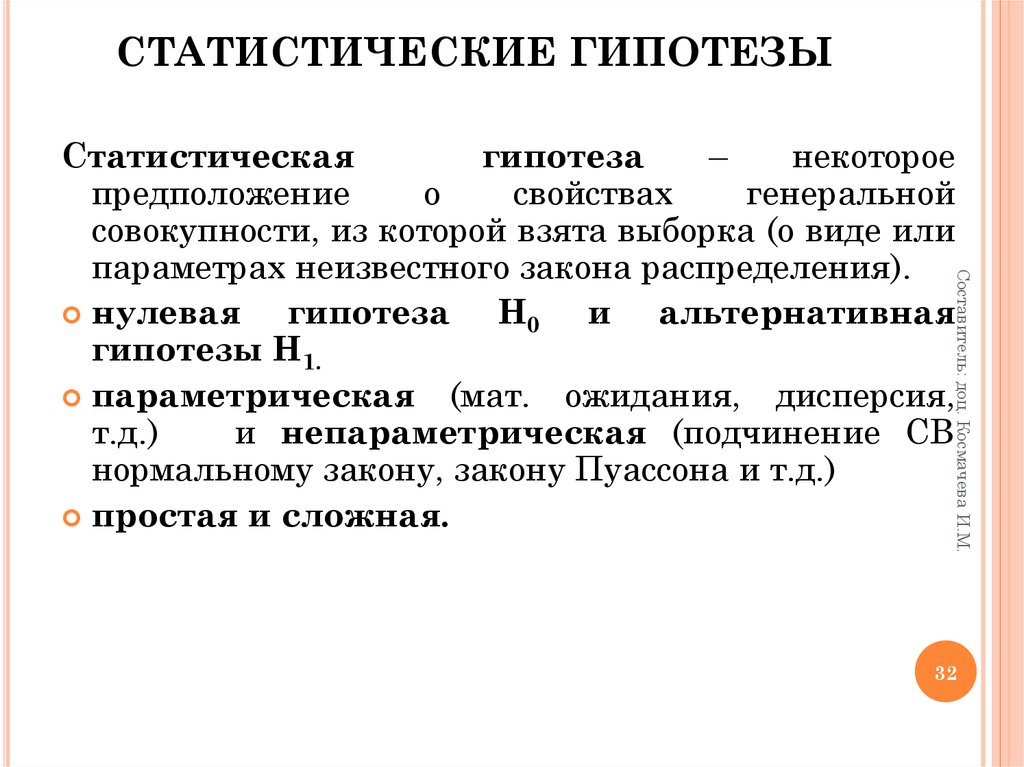

Статистическая гипотеза — предположение о виде распределения и свойствах случайной величины, которое можно подтвердить или опровергнуть применением статистических методов к данным выборки.

Ошибки первого и второго рода.

Ошибка первого рода состоит в том, что гипотеза

будет отвергнута, хотя на самом деле она правильная. Вероятность допустить такую ошибку называют уровнем значимости и обозначают буквой

«альфа»).

Ошибка второго рода состоит в том, что гипотеза

будет принята, но на самом деле она неправильная. Вероятность совершить эту ошибку обозначают буквой

«бета»).

Мощностью статистического критерия называется вероятность попадания данного критерия в критическую область, при условии, что справедлива конкурирующая гипотеза Н 1, т. е.выражение 1-β является мощностью критерия. Если уровень значимости уже выбран, то критическую область следует строить так, чтобы мощность критерия была максимальной.

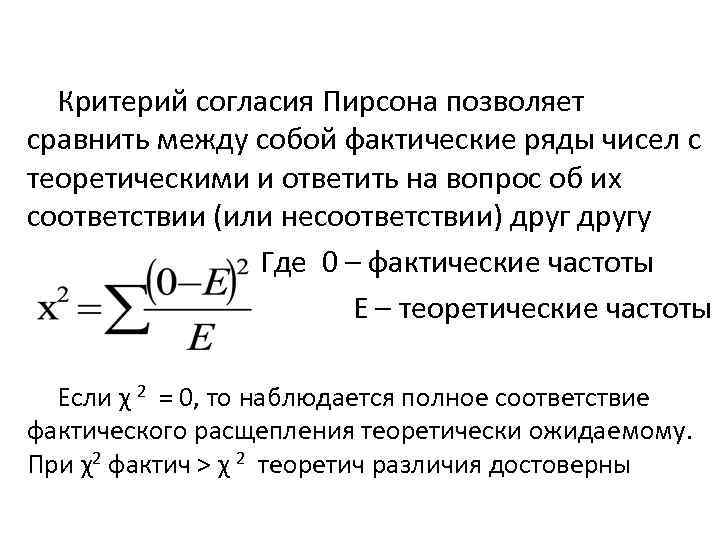

37.Критерий согласия Пирсона

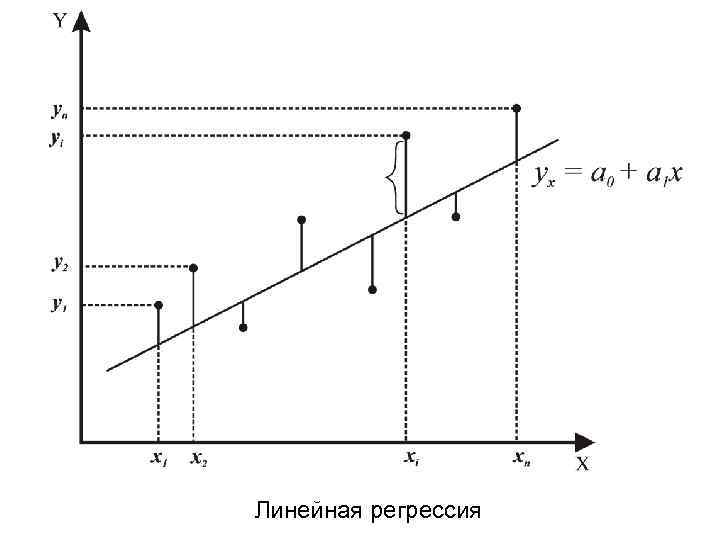

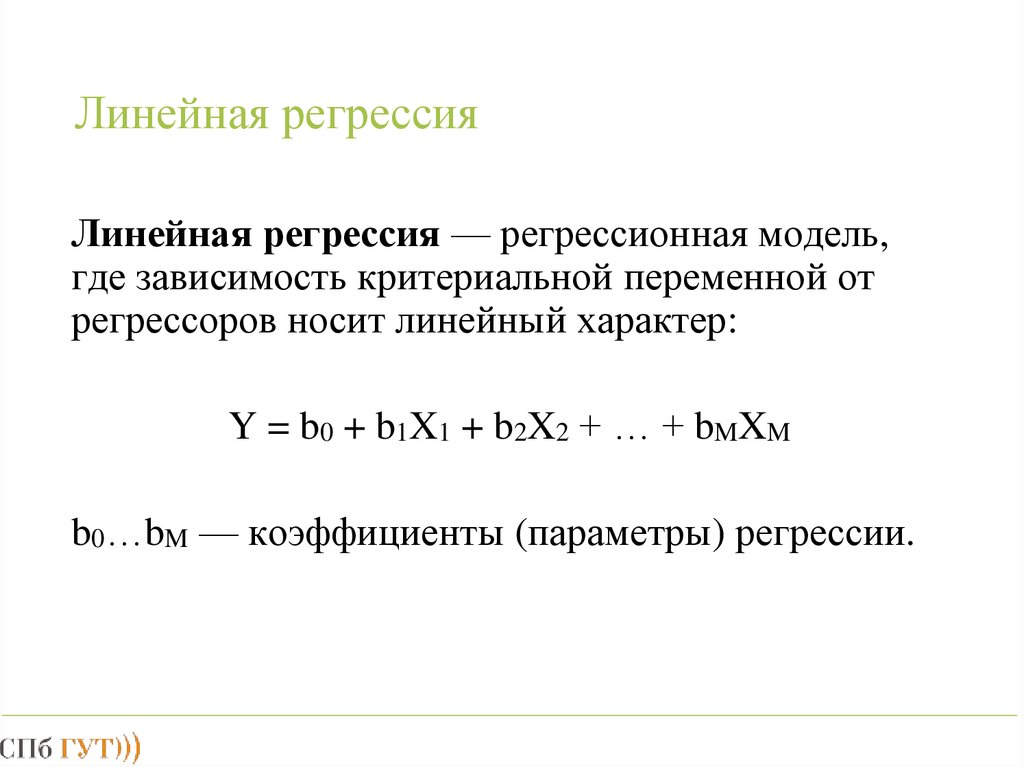

38.Линейная регрессия .